Das DeepRain-Projekt zielte auf die Entwicklung neuer Ansätze für die Kombination aus modernen Methoden des maschinellen Lernens mit leistungsstarken IT-Systemen für die Datenverarbeitung und -verbreitung kombinieren, um verbesserte hochauflösende räumliche Karten des Niederschlags über Deutschland zu erstellen. Grundlage für dieses Projekt war das mehrjährige Archiv von Ensemble-Modellvorhersagen des numerischen Wettermodells COSMO des Deutschen Wetterdienstes (DWD).

Sechs transdisziplinäre Forschungseinrichtungen arbeiteten in DeepRain zusammen, um eine durchgängige Verarbeitungskette zu entwickeln, die potenziell in der zukünftigen operationellen Wettervorhersage eingesetzt werden kann. Der Projektantrag hatte mehrere Herausforderungen identifiziert, die es in diesem Zusammenhang zu bewältigen galt. Neben den technischen Herausforderungen bei der Schaffung einer neuartigen Datenfusion von recht unterschiedlichen Datensätzen (numerische Modelldaten, Radardaten, Beobachtungen von Bodenstationen), dem Aufbau skalierbarer maschineller Lernlösungen und der Optimierung der Leistung der Datenverarbeitung und des maschinellen Lernens gab es verschiedene wissenschaftliche Herausforderungen im Zusammenhang 1. mit den kleinräumigen Strukturen von Niederschlagsereignissen, 2. Schwierigkeiten bei der Suche nach robusten Bewertungsmethoden für Niederschlagsvorhersagen und 3. den nichtnormalverteilten Niederschlagsstatistiken in Verbindung mit stark unausgewogenen Datensätzen.

Zum Projektstart von DeepRain war die Anwendung von maschinellem Lernen auf Wetter und Klimadaten noch sehr neu und es gab kaum Veröffentlichungen oder Softwarecodes, auf denen man aufbauen konnte. DeepRain leistete somit Pionierarbeit bei der Anwendung moderner Deep-Learning-Modelle im Bereich der Wettervorhersage. Gleichzeitig konnte man in den letzten drei Jahren einen exponentiellen Anstieg der Zahl der Veröffentlichungen in diesem neuen Bereich beobachten. Sehr oft handelte es sich dabei um Studien, die in Nordamerika oder China durchgeführt wurden. Globale Unternehmen wie Google, Amazon, NVidia oder Microsoft haben inzwischen Gruppen von Wissenschaftlern und Ingenieuren gegründet, um die Forschung zu “Wetter-KI” voranzutreiben und marktfähige Wetter- und

Klimaanwendungen mit Deep Learning zu entwickeln. Daher kam das DeepRain-Projekt zur rechten Zeit, da es eine Basis für maschinelles Lernen im Bereich Wetter und Klima in Deutschland geschaffen hat. DeepRain ermöglichte es dem Konsortium, das Potenzial von Deep Learning im Zusammenhang mit der erforderlichen gigantischen Datenverarbeitung zu erforschen und mit den internationalen Entwicklungen in diesem schnell wachsenden Forschungsbereich Schritt zu halten.

DeepRain konnte das geplante Ergebnis, d. h. den Bau eines Prototyps für einen durchgängigen Arbeitsablauf für hochauflösende Niederschlagsvorhersagen auf der Grundlage von Deep Learning, zwar nicht vollständig erzielen, aber es wurden alle damit verbundenen Forschungsfragen beantwortet und alle erforderlichen Bausteine für einen solchen Arbeitsablauf wurden entwickelt. Beispielsweise wurde die moderne Datenwürfel-Technologie erfolgreich eingesetzt, um vier- bis sechsdimensionale atmosphärische

Simulationsdatenwürfel auf der Basis von DWD-Daten für die Extraktion und Analyse bereitzustellen.

Zusätzlich zu den oben beschriebenen erwarteten Herausforderungen traten während des Projekts die folgenden schwerwiegenden Probleme auf: 1. ein weitreichender Datenverlust aufgrund von Hardwareausfällen im Frühjahr 2021, 2. die Covid-19-Pandemie von März 2020 bis heute und 3. Schwierigkeiten, hochqualifiziertes Personal zu finden – insbesondere in Zeiten, in denen die meiste Arbeit im Home-Office erledigt werden musste.

Die wichtigsten Ergebnisse von DeepRain sind:

- Datentransfer im Petabyte-Bereich von archivierten COSMO-DE-EPS-Vorhersagen von Bandlaufwerken des DWD und des RADKLIM-Datensatzes vom OpenData-Server zum Dateisystem JUST am JSC/FZ Jülich, Organisation und Bereinigung dieser Daten und Gewährleistung des Datenzugangs für alle Projektpartner,

- Parallelisierte Verarbeitung von COSMO-EPS- und RADKLIM-Daten (Ensemblestatistik, Remapping für Datenfusion und für das Einfügen in Rasdaman),

- Implementierung von Rasdaman Datenwürfel Array Datenbankservern am FZ Jülich und Ingestion von mehreren TBytes an Wetterdaten,

- Aufnahme des Jülicher Rasdaman-Servers in den EarthServer-Datenwürfel-Verbund,

- Weiterentwicklung von Rasdaman zur Beschleunigung des Dateneinfügens und -abrufs, Definition neuer benutzerdefinierter Funktionen für die Analyse topographischer Daten, Definition eines neuen Koordinatenreferenzsystems für gedrehte Polkoordinaten und Vorbereitung der Anbindung von Prozessierungsketten für maschinelles Lernen,

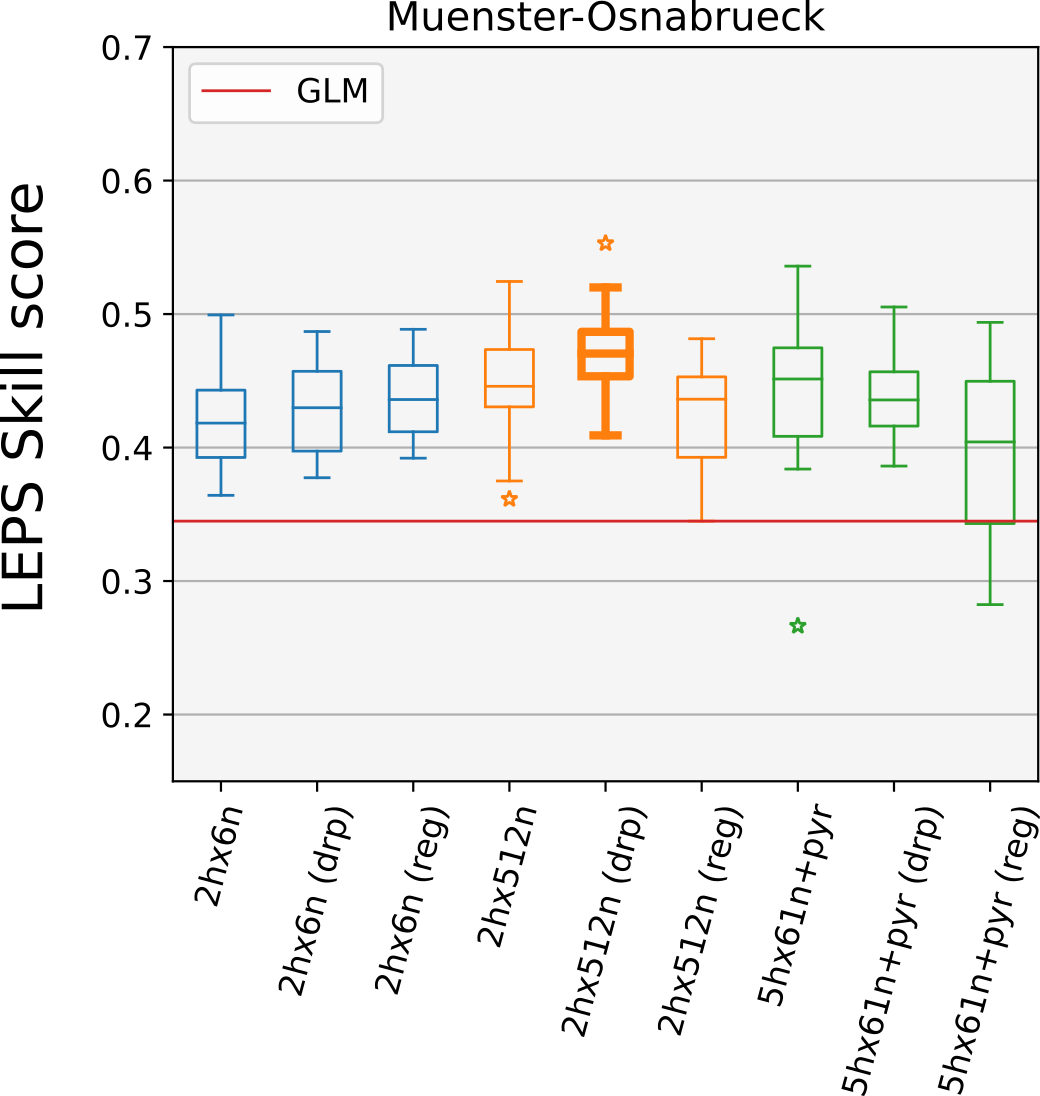

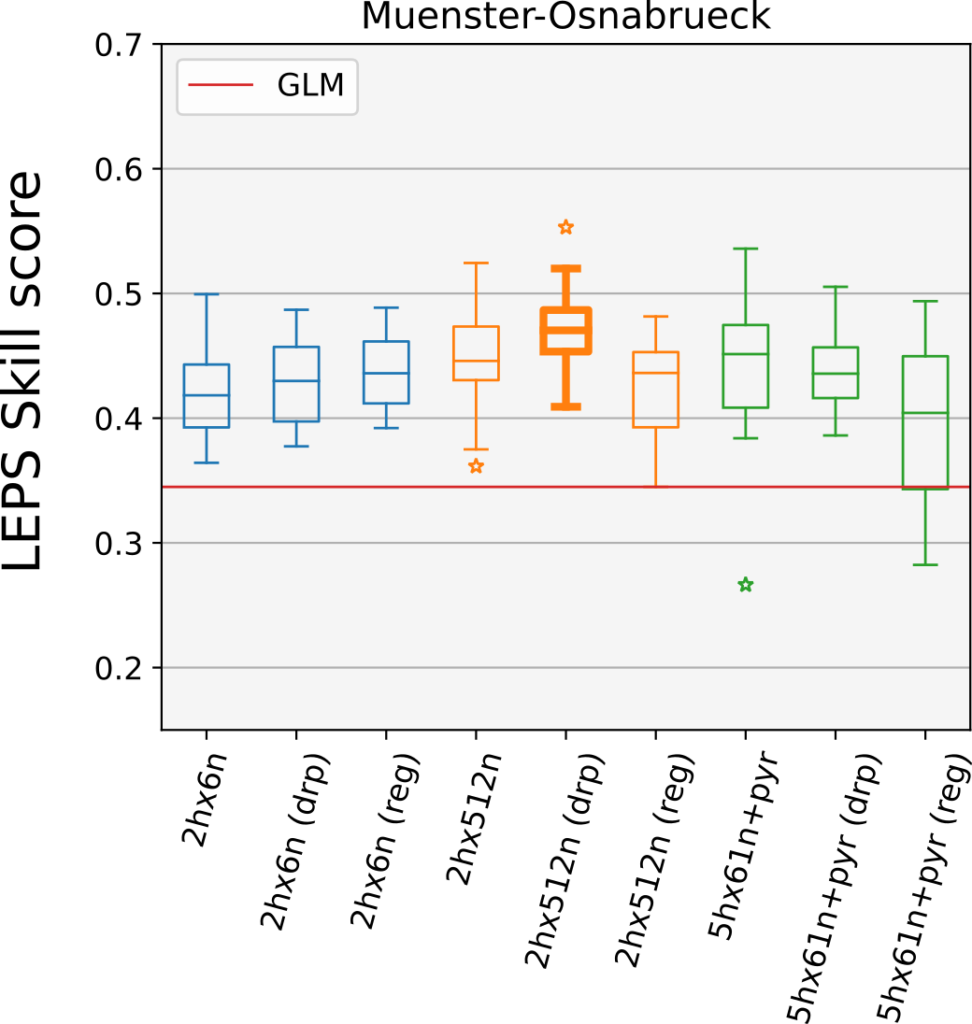

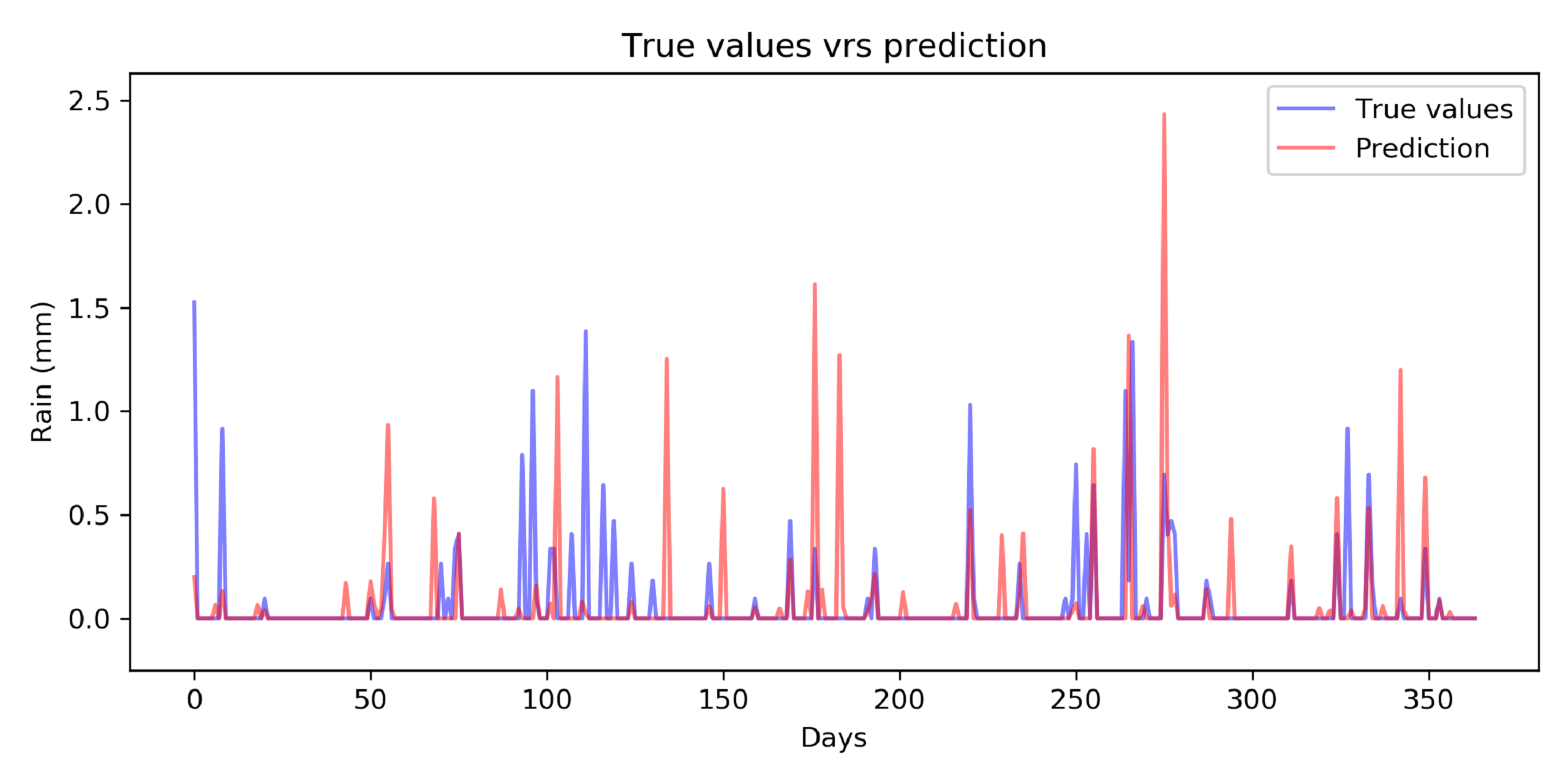

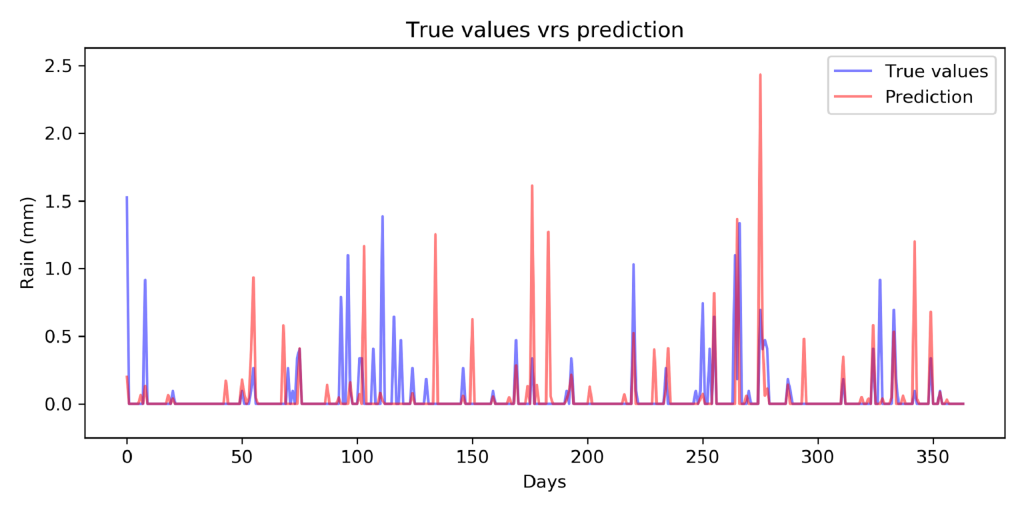

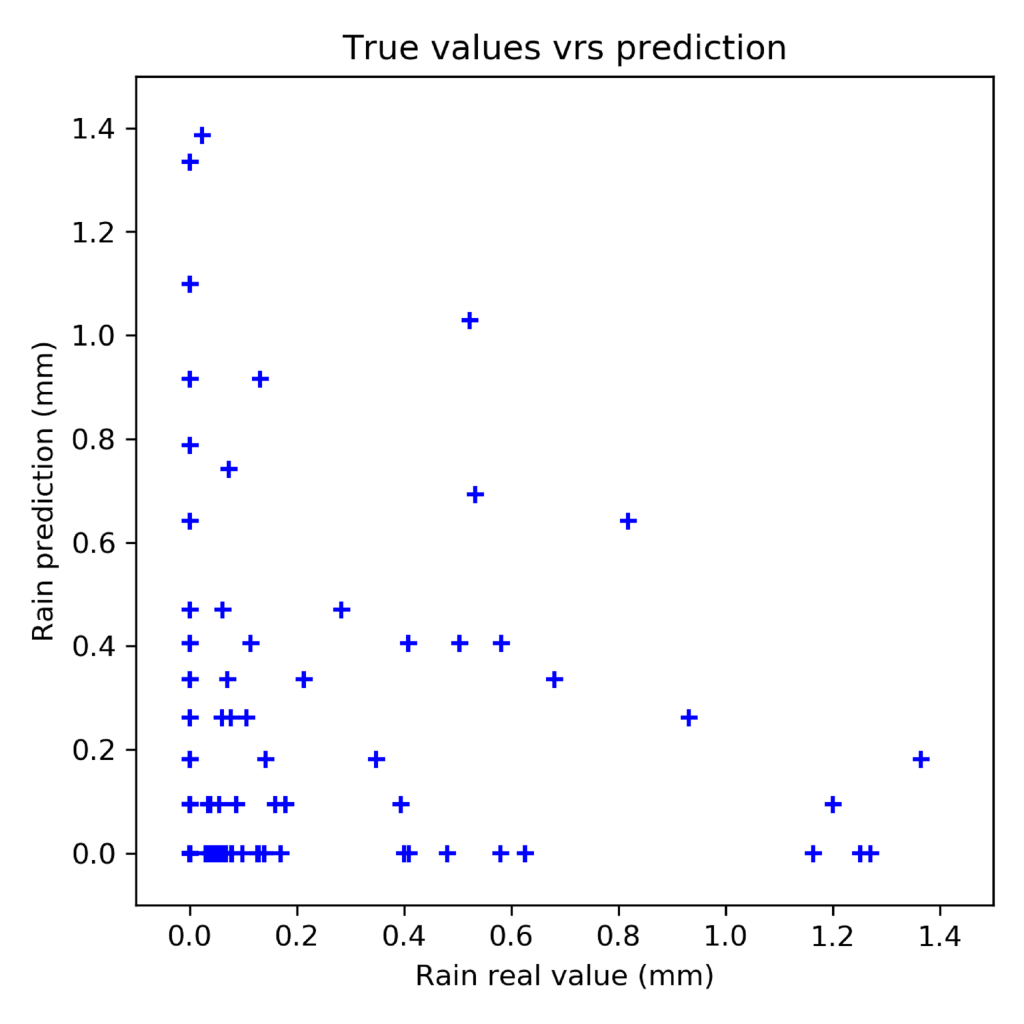

- Entwicklung von statistischen Downscaling-Techniken und maschinellen Lernmodellen, um:

- dichotomen und quantitativen Niederschlagsvorhersagen an Stationsstandorten zu generieren und

- Gebietsvorhersagen in der Auflösung der RADKLIM-Radardaten zu erzeugen,

- Erforschung neuer Verifikationsstatistiken auf der Grundlage partieller Korrelationen und des Regression Boostings.

In diesem Bericht geben wir einen detaillierten Überblick über die Arbeit und das Erreichte im Rahmen des DeepRain-Projekts. Dieser Bericht ist in fünf Abschnitte gegliedert: In Abschnitt 1 stellen wir den Arbeitsplan aus dem Projektantrag vor und geben Informationen über den Stand der Erbringung jeder einzelnen Aufgabe, um einen kompakten Vergleich zwischen dem Projektplan und seinen Ergebnissen zu ermöglichen. In Abschnitt 2 werden dann die im Rahmen des Projekts durchgeführten Arbeiten für jedes einzelne Arbeitspaket detailliert beschrieben. In Abschnitt 3 werden die Projektergebnisse und deren mögliche künftige Nutzung erörtert. In Abschnitt 4 geben wir einen allgemeinen Überblick über die außerhalb des Projektes erfolgten Fortschritte in den Forschungsbereichen, die mit DeepRain in Verbindung stehen. Im Einzelnen sind dies: maschinelles Lernen für die Niederschlagsvorhersage, Methoden zur Bewertung von Niederschlagsvorhersagen, Umgang mit Big Data und FAIR-Datenpraktiken. Schließlich werden in Abschnitt 5 alle Zeitschriftenveröffentlichungen, Datensätze und Softwarepakete sowie geplante Einreichungen aufgeführt, die aus dem DeepRain-Projekt hervorgegangen sind.

Abschnitt 6 beinhaltet das Literaturverzeichnis.

Link zum vollständigen Abschlussbericht: https://hdl.handle.net/2128/33144